人工智能帶來的帶寬速率挑戰

公開數據顯示,從GPT-1到GPT-3,模型的參數量從1.1億個增長到了1750億個,GPT-4模型的參數達到1.8萬億個。根據市場調查機構TrendForce的數據,如果以英偉達A100顯卡的處理能力計算,GPT-3.5大模型需要2萬塊GPU來處理訓練數據。

ChatGPT,加上紛至沓來的AI大模型,AIGC(人工智能生成內容)產業不僅帶來檢索效率和工作效率的提升,同時由于大模型需要大量的數據和算力進行訓練和運行,并在使用過程中產生大量新的數據,因此除了GPU計算之外,對于高速存儲和數據交換也有更高的要求。

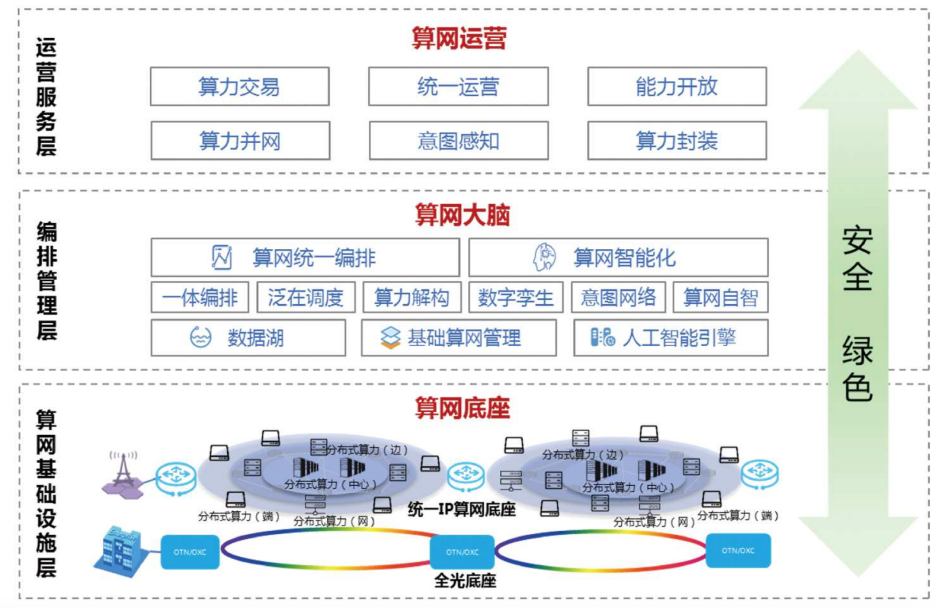

根據中國移動在《算力網絡白皮書(2021年版)》中公布的算力網絡體系架構。在算網基礎設施層,即算網底座,全光傳輸底座已是行業的共識。先進算力遵循“木桶效應”的,算力、存儲和網絡傳輸三大核心環節,一個出現短板,整個系統的性能就會出現巨大的下滑,這也是云服務商積極部署800G以太網交換的原因。

Dell’Oro Group 最近發布的一份《以太網交換機五年預測》報告顯示,2021 年至 2026 年間,以太網交換機數據中心市場預計將以接近兩位數的復合年增長率增長,未來5年累計支出將接近1000億美元。預計400Gbps及更高的速度將占支出的一半,到2025年,800Gbps將超過400Gbps。

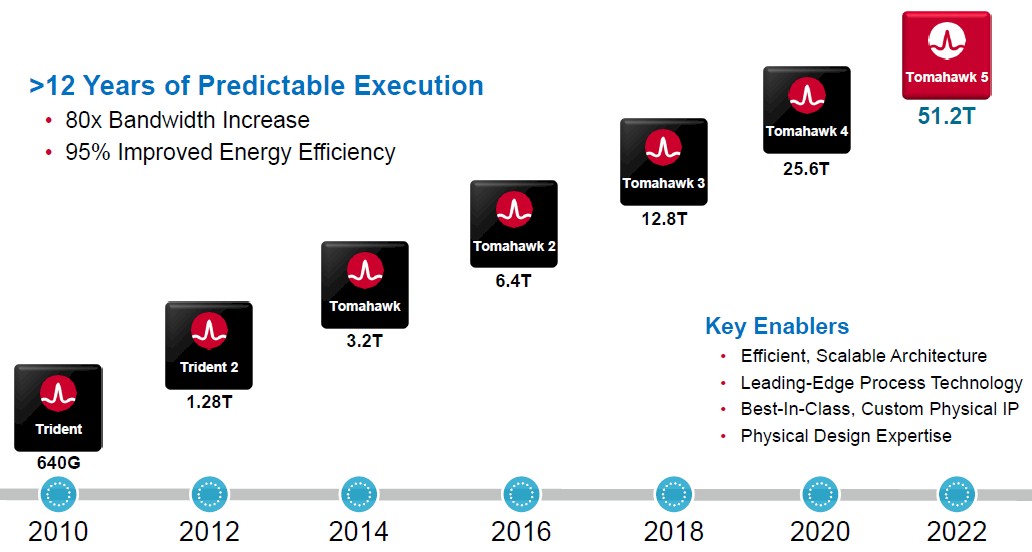

交換芯片的容量每兩年翻一倍

博通始終代表著交換芯片的最先進解決方案,Tomahawk系統芯片是高帶寬交換機平臺芯片,Tomahawk 5是Broadcom推出的5納米工藝的51.2T交換容量的芯片,主要針對超大規模企業和云服務商用交換機和路由器芯片市場。

Tomahawk 5可以驅動51.2TB/秒的總帶寬,64個以800Gb/秒運行的端口、128個以400Gb/秒運行的端口和256個以200Gb/秒運行的端口,超大規模企業和云服務商喜歡具有128端口基數、每端口運行速度為400Gb/秒的交換機,其中 64個端口向下連接到機架中的服務器,64個端口向上連接到網絡結構的主干層。人工智能服務器集群可以使用256個以200Gb/秒運行的端口,可以極大滿足人工智能計算的數據交換需求。

這些大容量交換芯片一般都是大型的FCBGA封裝,芯片尺寸大于60cm2,超過8000個LGA引腳。

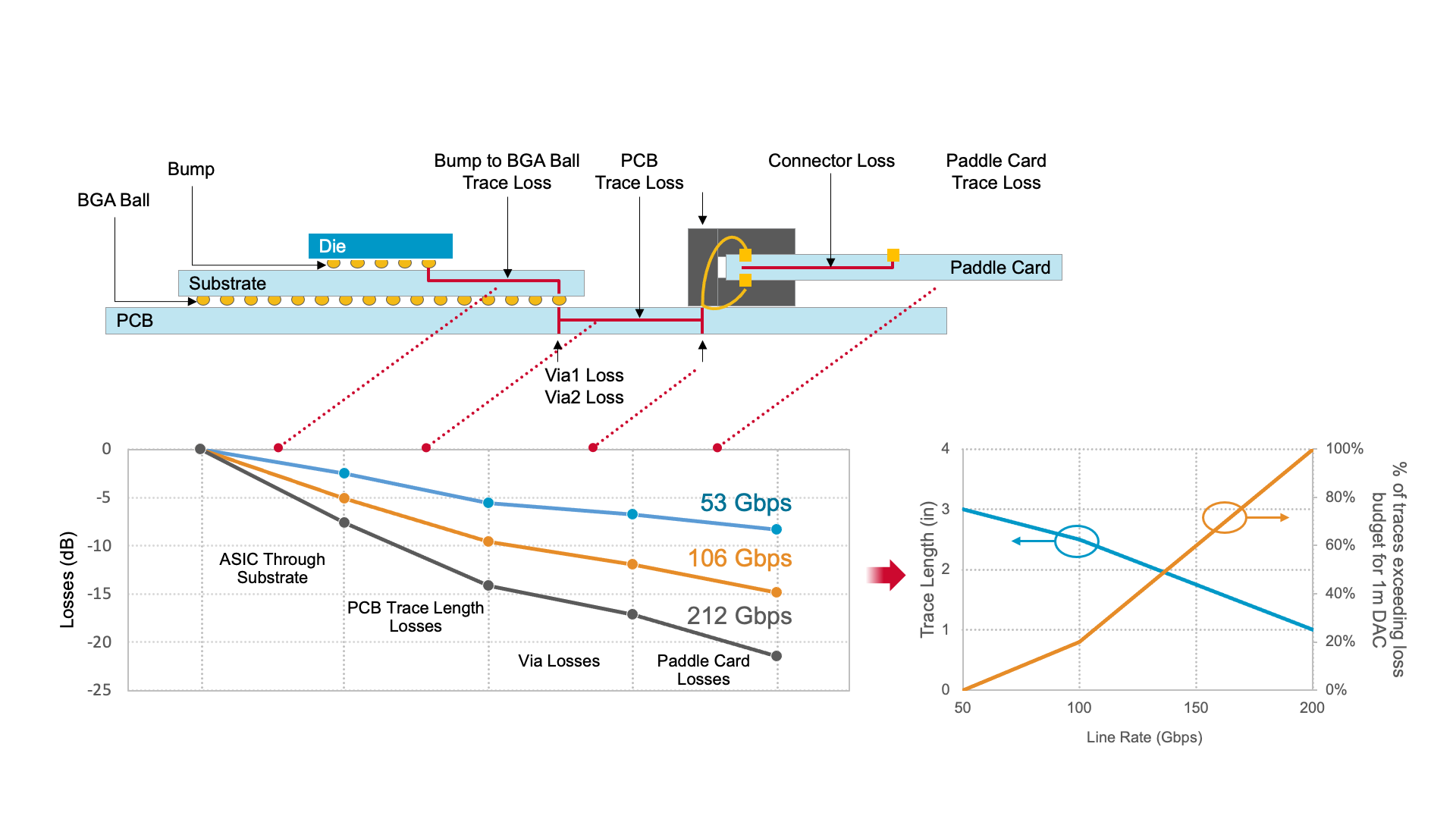

光進銅退,800G交換機的互聯方案

隨著高速信號的傳輸速率從50G增加到100G再到200G,傳輸系統的損耗從低于10dB增加到超過20dB。在信號傳輸速率超過200G時,PCB板的互聯復雜性增加,幾乎所有信號線的走線長度都將超出1m DAC線路傳輸的損耗預算。

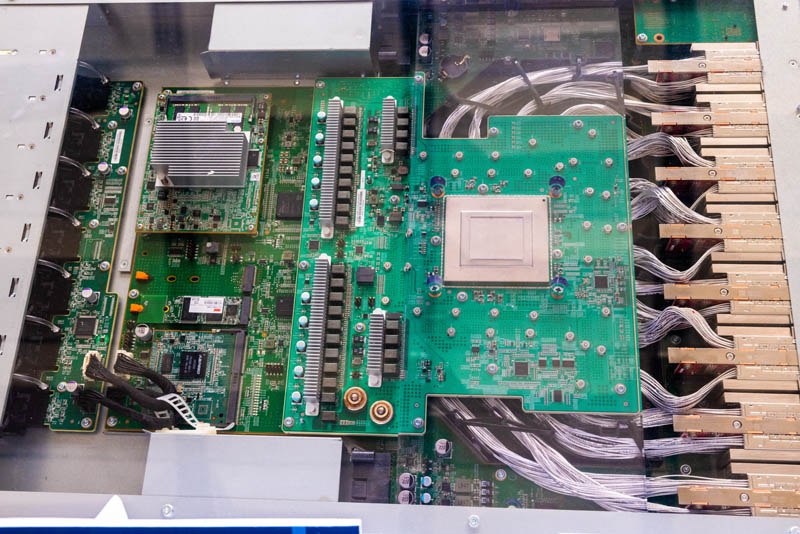

Celestica在OCP Summit 2023上展示了一款使用Broadcom TomaHawk 5交換芯片的800G交換機。采用flyover cables的銅纜技術來縮短布線及散熱問題。

flyover cables銅纜技術,很好解決了800G交換機的設計與技術挑戰點:

更容易走線到可插拔的光模塊(線長更短信號更好)。由于800G交換機基于112Gpbs速率及密集的交換線路布線路,在PCB上走線時其信號噪聲很難最小化,其解決主案一種是選擇共封裝光學器件(CPO)方案,另一種就是易操作/低成本的flyover cables銅纜方案;

功耗散熱問題:800G交換芯片及光模塊需要更大的散熱器來進行冷卻。由于采用了flyover cables銅纜方案,中間多出大量空間,這些空間被利于安裝大型散熱器。

共封裝光學器件(CPO)是另外一個替代方案。隨著800G交換機的產品化,速率達到224Gbps,CPO會越來越流行。

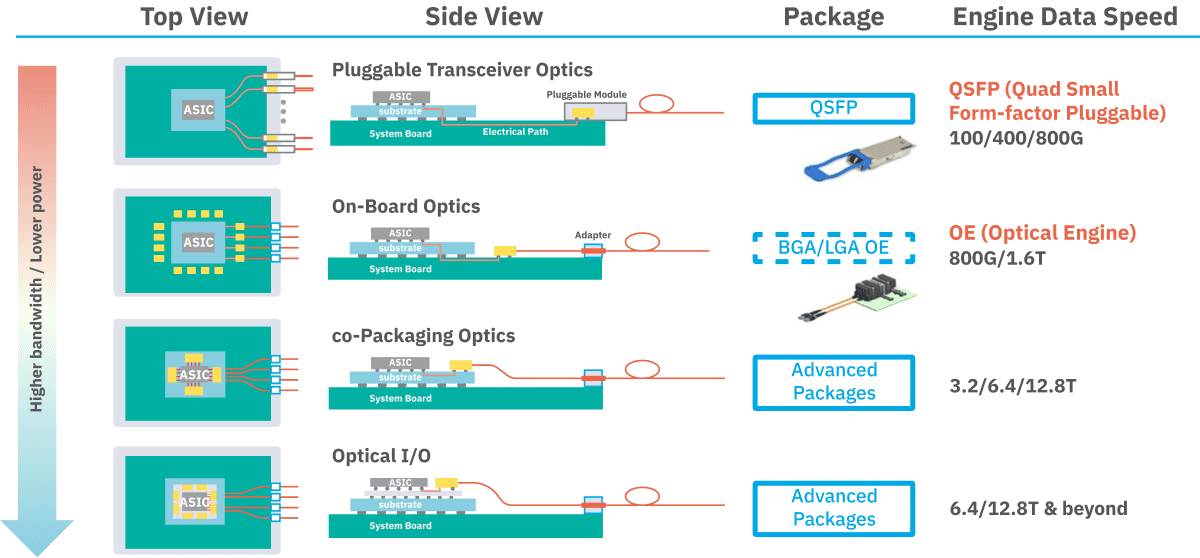

光模塊集成的演變過程

圖片來自:日月光

在目前的服務器上,數據是通過光模塊將光信號轉換成電信號,再將數據傳輸至交換機或者服務器中。

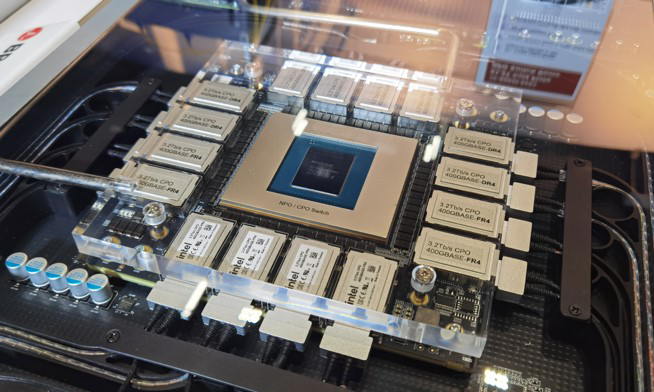

在共封裝光學器件(CPO)中,光接收器、放大器和DSP這些光模塊上的功能器件會被集成到PCB載板上。通過CPO方案,可以降低30%的功耗,降低40%的成本,數據交換密度提升之后,體積變得更小。

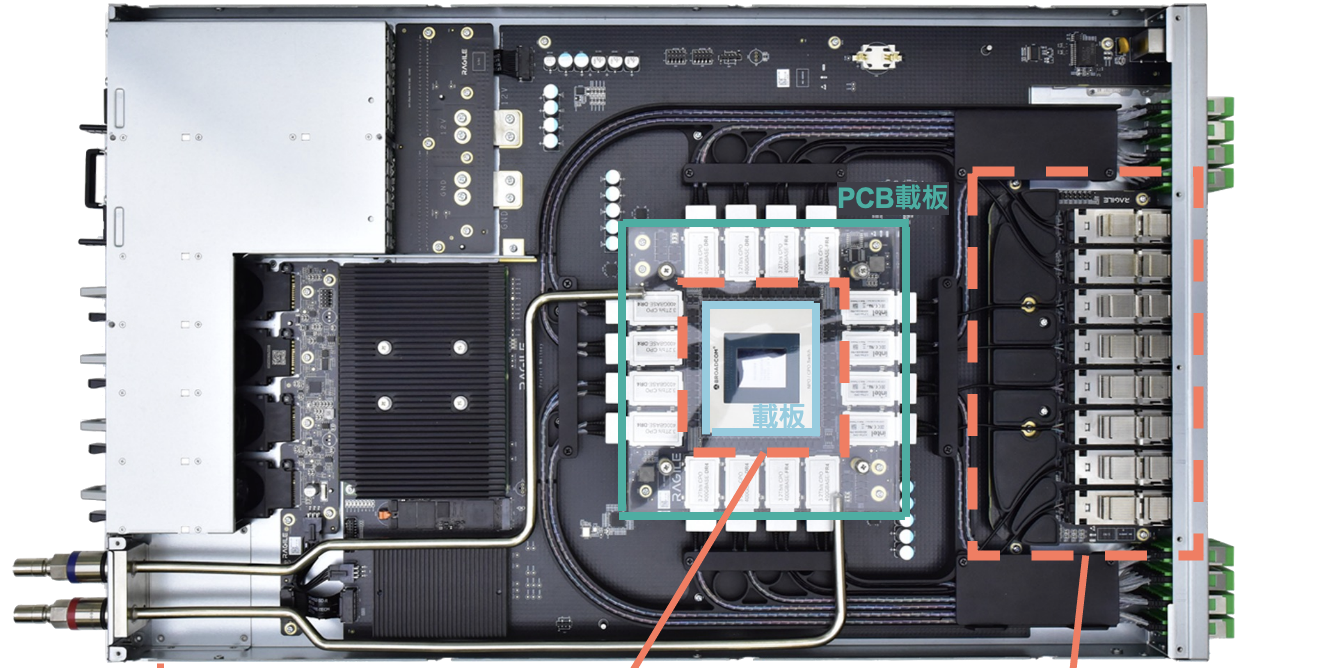

銳捷網絡25.6T硅光CPO交換機

銳捷網絡51.2T硅光NPO交換機

聲明:文章內容整理自網絡公開素材,版權歸原作者平臺所有,僅用于信息分享,如有侵權請聯系刪除。